Appearance

GNN谱图理论简述

XJTU_zsy

从代数角度分析GNN的工作原理

谱图理论简述

从代数角度分析GNN的工作原理

1.拉普拉斯算子简述

简介

我们知道拉普拉斯算子是一个二阶微分算子,$\Delta f = \nabla ^2 f = \Delta ·\Delta f $ 我们通常在计算函数的二阶导数时用到它。

定义上看:它反映的是函数变化率的变化率。

傅里叶级数简述

可以由

从而可以用

显然,这个

进一步地,我们找到了一组基底

思想借鉴

1.定义图拉普拉斯算子

图

离散拉普拉斯算子

推广到图:

单个节点的拉普拉斯算子:

则所有节点:

其中D是度对角阵。*表示通常意义的内积。

2.图频域基底

记

傅里叶变换

在傅里叶级数的基础上,用复数欧拉公式可以较为容易推导出傅里叶变换为:

就是把上面傅里叶级数的n从整数变到w实数范围以后,将原函数对各个基底作投影。

类似的:

定义图上傅里叶变换

逆变换

卷积和频域

卷积:单位脉冲函数和原函数卷积为原函数

信号处理:时不变系统中,处理作用于原函数,相当于处理作用于单位脉冲函数后和原函数卷积

卷积和频域:时域卷积等于频域相乘后逆变换。

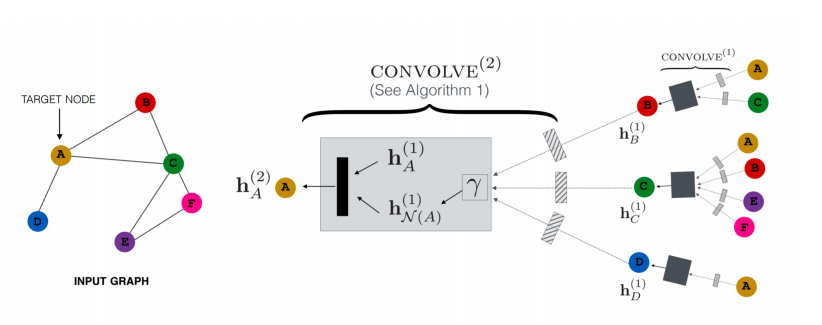

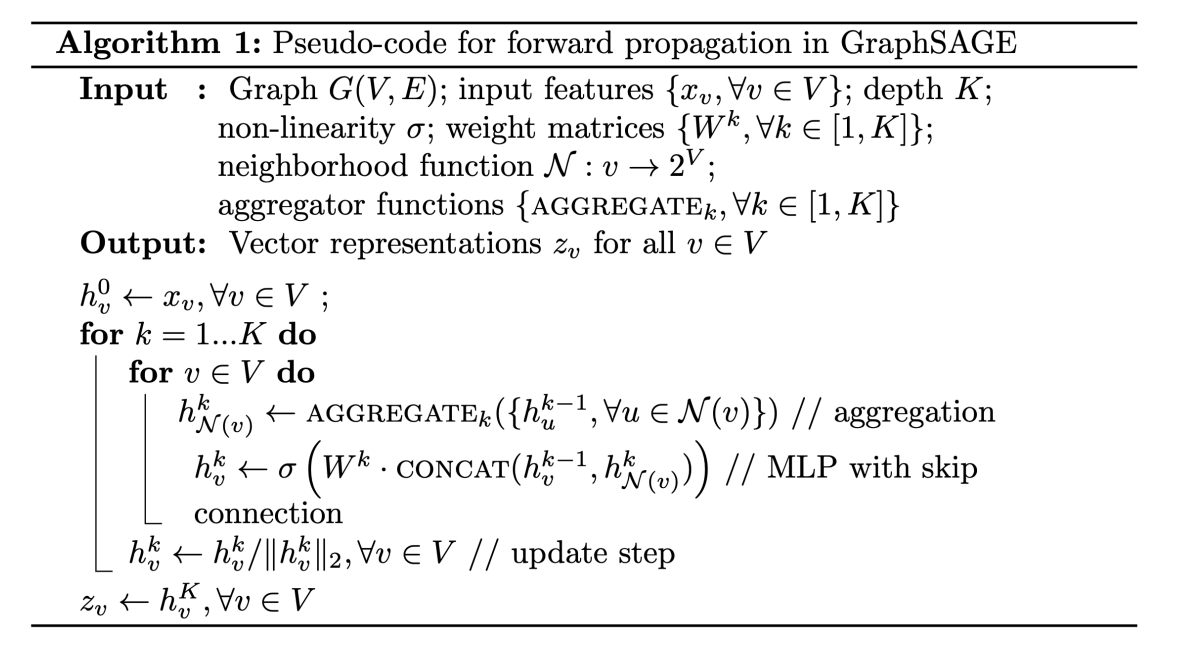

对图信号处理

冲击函数在图上就是每个节点施加一个constant([1,1,1....])。

在

对

用一阶近似并取得

最后加上激活函数得到了单层GCN:

直观理解这个公式

聚合邻居节点的信息。

reference

Convolutional Neural Networks on Graphs with Fast Localized Spectral Filtering